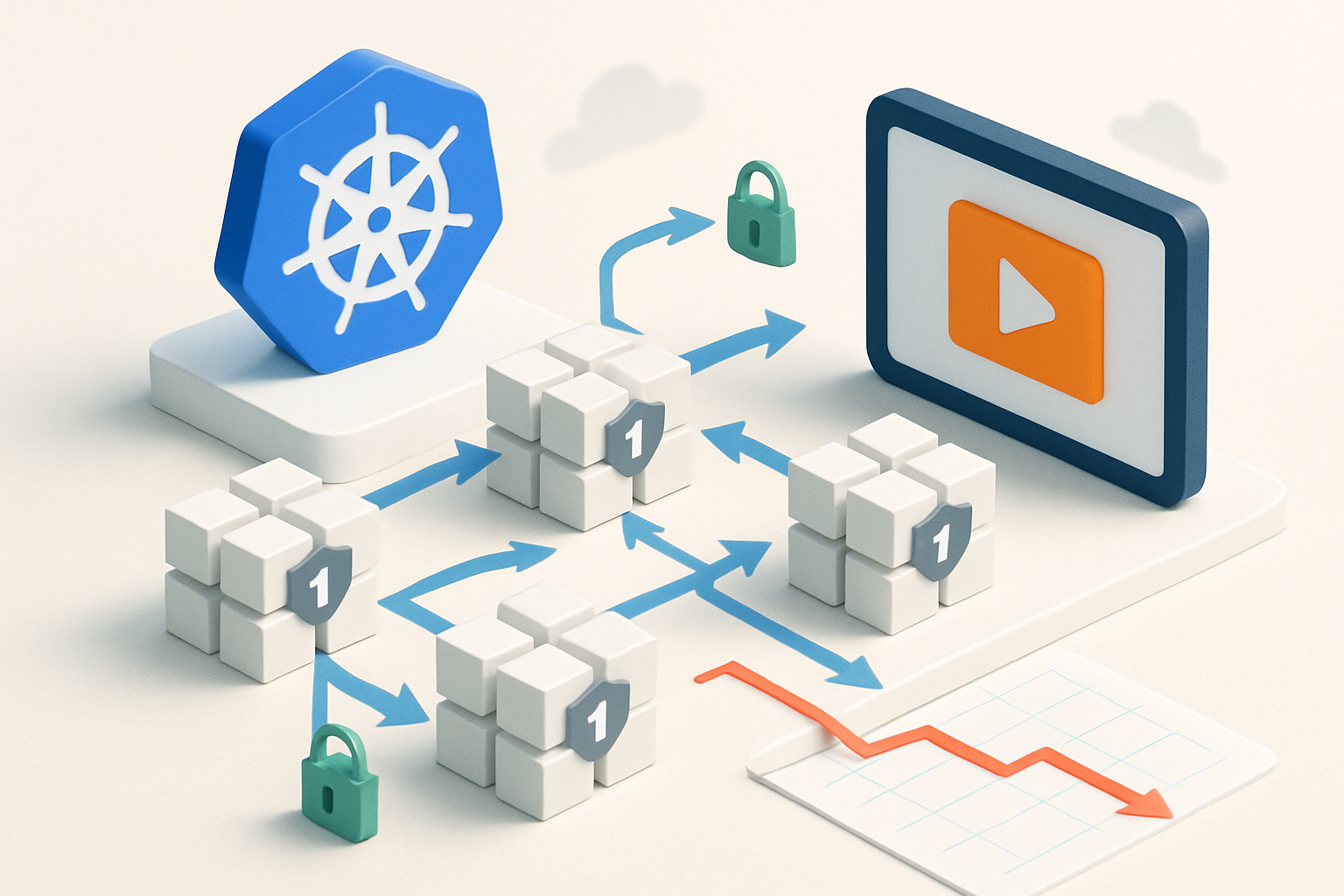

教育SaaSの現場で“軽いメッシュ”が効いた理由

教育プラットフォームを提供するImagine Learningは、Kubernetes上のマイクロサービスを守り、速くし、安くする必要がありました。

クラウド費用の高止まり、ネットワーク帯域コスト、そして増え続ける脆弱性対応の重さが、チームの手を取っていたからです。

そこで同社が選んだのが、CNCF卒業プロジェクトのサービスメッシュ、Linkerdです。

CNCFとBuoyantの事例では、Linkerd採用により、計算資源80%削減、メッシュ関連CVE 97%減、データ転送コスト40%減というインパクトが報告されています。

数字だけではなく、運用の静けさも取り戻せた点が見逃せません。

Imagine Learningが直面した3つの壁

膨らむクラウド請求と散在する最適化余地

マイクロサービスの増加は、CPU・メモリ・帯域の増加と表裏一体です。

ピークトラフィックに合わせた過剰プロビジョニングや、L7通信の非効率が積み上がっていました。

“直すべき”脆弱性の雪崩

サイドカーやコントロールプレーンの依存関係が多いほど、CVEの監視・パッチ当ては重労働になります。

脆弱性の“多さ”が、そのままセキュリティ負債になっていました。

可観測性と信頼性のジレンマ

可観測性のためのエージェントや重いプロキシは、オーバーヘッドを生みます。

SLOを守るための仕組みが、コストや遅延の新たな源泉になる矛盾がありました。

Linkerdを選んだ決め手:軽さ・シンプルさ・安全性

超軽量プロキシとシンプル設計

Linkerdは超軽量なRustベースのデータプレーンと、シンプルなコントロールプレーンで構成されます。

運用負荷を増やさず、メッシュの基本価値に集中できる点が強みです。

- 小さなフットプリント:ノード密度を上げやすい

- 設定の明瞭さ:導入・運用の学習コストが低い

- 安全第一の実装:CVE発生源を構造的に抑制

Linkerd is the ultralight, ultra secure service mesh for Kubernetes.

導入プロセス:最小介入で確実に効かせる

1. 対象の明確化とスコープリング

全サービスを一気に巻き込まず、顧客影響の少ない内部APIから着手。

レイテンシやスループットのベースラインを測り、KPI設計を先に固めます。

2. Linkerdの段階的オンボーディング

- コントロールプレーンのデプロイ

- 対象Namespaceへ自動インジェクション設定

- トラフィックの一部をメッシュ化して計測

3. 信頼性機能の有効化

- mTLSのデフォルト化:暗号化とサービスアイデンティティの確立

- リトライ/タイムアウト:L7での堅牢化とリソース節約

- コネクションプーリング:帯域とCPUの無駄を削減

こうした“最小介入”の積み重ねで、障害リスクを抑えつつ効果を可視化します。

どこでコストが下がるのか:技術的メカニズムの紐解き

計算資源80%削減の背景

- 軽量プロキシにより各Podのオーバーヘッドを抑制

- 接続の再利用・圧縮、HTTP/2やgRPCの効率化でCPUを節約

- 安定したバックオフ/リトライでスパイク時のスレッシングを抑止

データ転送コスト40%減の仕組み

- 接続多重化でコネクション管理を効率化し、冗長転送を削減

- L7メトリクスで無駄な呼び出しパターンを可視化・是正

メッシュ関連CVE 97%減の理由

- Rustによるメモリ安全なデータプレーン採用

- 依存の最小化とシンプル設計で攻撃面を縮小

“軽く、単純で、安全”はそのままTCO削減とリスク低減に直結します。

可観測性はどう変わるか:見たいものだけ、負担なく

メッシュならではのL7可視化

アプリ改修なしに、リクエスト成功率、レイテンシ、エラーパターンを取得。

サンプリングと集約が巧みで、メトリクス取得のために新たな重さを持ち込みません。

- トポロジの自動把握で“遅い経路”を特定

- サービスレベルのSLO監視が設定容易

結果として、原因特定の時間が短縮し、人的コストにも効いてきます。

現場Tips:Linkerdでコストを落とす設定の勘所

- Resource requests/limitsの再設計:軽量化分を密度向上にリサイクル

- HTTP/2/gRPCの活用:多重化とヘッダ圧縮でCPU/帯域を削減

- リトライ・タイムアウトの粒度調整:スパイク時の無駄撃ちを抑止

- トラフィック分割:段階的メッシュ化とベンチマーク比較を徹底

- eBPF/ネットワーク調整と併用:ノード全体のI/O効率を相乗最適化

“計測→調整→再計測”の短サイクルを回すことが、費用対効果を最大化します。

リスクと落とし穴:うまくいかなかった時の見直しポイント

メッシュの“やり過ぎ”

全サービスを一気に巻き込むと、設定ドリフトや思わぬ相性問題が表面化します。

小さく始め、段階的に広げるのが安全です。

可観測性の名の下の過収集

メトリクスは増やしやすい一方、保管・集約・ダッシュボードのコストは隠れがちです。

本当に見るべき指標に絞る設計が重要です。

セキュリティ機能の“穴”

mTLSが標準とはいえ、証明書ローテーションやアイデンティティの境界設計は必要です。

ゼロトラストの原則で、ネットワーク境界を再定義しましょう。

導入のための実践ロードマップ(30/60/90日)

30日:検証とベースライン確立

- 対象2〜3サービスを選定し、LinkerdをPoC導入

- レイテンシ・CPU・帯域・失敗率のベースライン計測

60日:スケールとSLO運用

- 対象を5〜10サービスへ拡大、mTLSと基本ポリシーを標準化

- リトライ/タイムアウト、接続多重化で効率化を実装

90日:コスト最適化の定着

- リソースRequests/Limitsの再設計、オートスケールを再調整

- 可観測性指標の棚卸しとダッシュボードの簡素化

まとめ:軽さは正義、そして継続が力

Imagine Learningの結果が示す通り、Linkerdの軽さとシンプルさは、コストとリスクの両輪に効きます。

80%の計算資源削減、CVE 97%減、データ転送コスト40%減は、単発のチューニングでは届きません。

メッシュ“そのもの”を軽く、安全に保つ選択が、Kubernetes時代の標準解になりつつあります。

最後に大切なのは、計測と改善のサイクルを壊さないこと。

Linkerdはその速度を落とさず、現場の余白を取り戻してくれます。

コメント