AIの勝敗を決めるのはデータの「つながり」

AIエージェントを本番で賢く走らせる鍵は、クリーンで絶えず更新される“つながったデータ”。

静的なデータに頼るだけでは、意思決定の鮮度も精度も伸びない。

リアルタイムに流れるイベントと、履歴を蓄えるレイクハウスを一つに束ねる設計が必須だ。

この文脈で、IBMがデータストリーミングの旗手Confluentを約110億ドルで買収した狙いは明快だ。

Kafkaベースの「Data in Motion」をIBMのAI/ガバナンス群と統合し、“スマートデータ基盤”を企業に届ける。

日本企業にとっても、遅延の少ないデータ統合と厳格なガバナンスを両立する道が現実味を帯びる。

何が起きたのか:IBM × Confluentの買収全体像

IBMは現地時間12月8日、Confluentの全株式を1株31ドルで取得する正式契約を発表した。

企業価値は約110億ドルで、完了は2026年半ばの見込みと報じられている。

公式発表と主要メディアは、生成AI時代のデータ基盤強化を主眼とする点で一致している。

「IBMとConfluentは、エンタープライズ生成AI向けスマート・データ・プラットフォームの構築に向け合意した」

IBM Japan Newsroom

報道のハイライト:

- ZDNET Japan:110億ドル、完了は2026年半ばを予定

- マイナビニュース:目的は生成AI用データプラットフォームの強化

- Confluent公式ブログ:買収合意を告知

- Bloomberg:AIサービス拡張への大型投資

- Publickey:Kafkaの作者らが創業したConfluentの位置づけ

「スマートデータ基盤」とは何か:構成要素と価値

定義

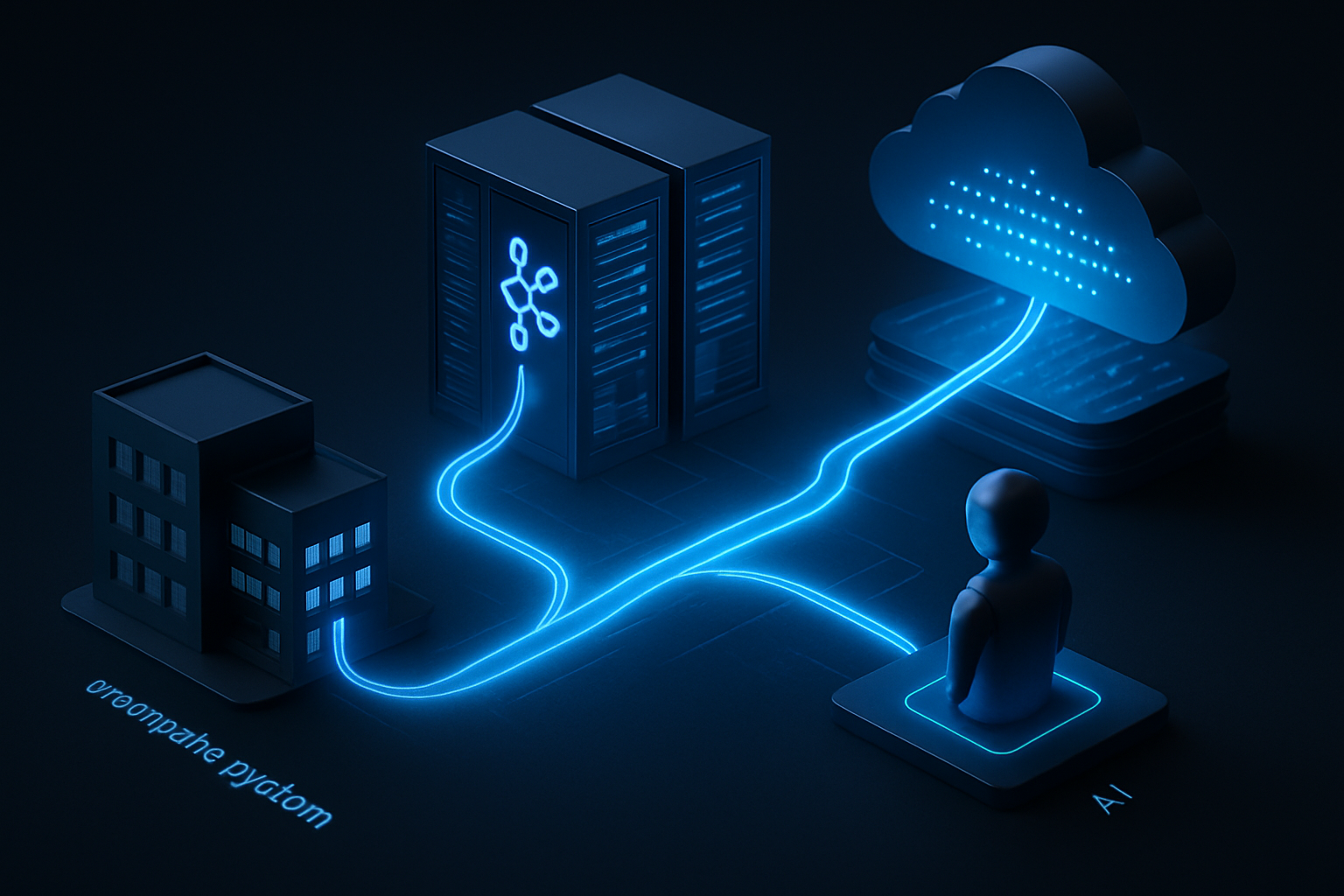

スマートデータ基盤は、リアルタイムのイベントストリームと履歴データを統合し、ガバナンスと自動化を前提にAIへ安全に供給するための企業プラットフォームだ。

“常に新しい意思決定ができるAI”を現場に届けるための土台といえる。

主なコンポーネント(想定)

- Data in Motion:Confluent(Kafka/Flink)のマネージド基盤、Stream Governance、Schema Registry、Cluster Linking

- Data at Rest:IBM watsonx.data(レイクハウス)、既存DWH/データレイクとの連携

- AI/ML:watsonx.ai、特徴量管理、RAG/ベクトル検索

- ガバナンス:watsonx.governance によるポリシー、リネージ、リスク管理

- 自動化/運用:Red Hat OpenShift、Instana、Turbonomic などの可観測性/FinOps

要は、「流す」×「貯める」×「守る」×「賢く使う」を一体化する。

Confluentが担うのは超低遅延の取り回しとスキーマ/系譜管理、IBMはAI・レイクハウス・ガバナンス・ハイブリッド運用で骨格を補完する格好だ。

アーキテクチャの全体像:イベント駆動のAIデータパイプライン

典型的な参照アーキテクチャはこうなる。

- 取り込み:CDC(Debezium等)で業務DB更新をKafkaへ。IoT/ログ/SaaSもコネクタで吸収

- 変換/強化:Flink/ksqlDBでクレンジング、データ契約で型・意味を固定化

- 配信:業務マイクロサービス、ルールエンジン、アラートへ即時配送。Cluster Linkingでマルチリージョン冗長

- 蓄積:レイクハウスにバッチ/マイクロバッチで永続化。メタデータとリネージを同期

- 検索/生成:ドキュメントや特徴量をベクトルDBに投影し、RAGで最新知見を生成

- エージェント:イベントをトリガに「観測→推論→行動」を繰り返す。行動結果も再びイベントとして循環

ポイントは“二層構造”。

即時レスポンスが要る経路はKafkaで直行、後段でレイクハウスに集計・検証して長期学習とレポートに回す。

どちらも同じスキーマとリネージで管理し、齟齬を断つ。

使い方ガイド:最短90日の導入ロードマップ

Phase 0(~2週)評価と設計

- ユースケース選定:詐欺検知、在庫最適化、品質異常検知など

- データ契約の素案作成:イベント名、必須フィールド、SLA、遅延・順序保証

- PoC用にConfluent Cloudとwatsonx環境を用意

Phase 1(~6週)ストリームの骨格づくり

- CDC/ログ取り込みとSchema Registry運用開始

- Flink/ksqlDBでクレンジングとPIIマスキング

- Cluster LinkingでDRを構成。可観測性はInstanaで統一

Phase 2(~10週)AI統合とガバナンス

- レイクハウス連携、メタデータ・リネージの自動収集

- RAG/特徴量ストアと接続。watsonx.governanceでポリシー適用

- コスト監視(Turbonomic)とSLO設定、運用Runbook作成

Phase 3(~13週)本番化

- カナリアリリース、バックプレッシャー試験、フェイルオーバー演習

- FinOpsルールと課金タグ、容量計画の自動化

- 事後分析のダッシュボードとKPI定義(遅延、精度、MTTR)

主要ユースケース:日本企業で効く「即効薬」

- 製造:設備センサーをKafkaに集約し、Flinkで異常スコアを算出。閾値超過でエージェントが保全指示。良否判定はレイクハウスに蓄積しモデルを継続学習

- 小売/EC:行動イベントを秒単位で集約し、パーソナライズを配信。カート放棄や在庫切れ予兆をリアルタイムに補正

- 金融:カード利用パターンをストリーミングで連鎖分析。高リスクのみ二要素認証に昇格し、UXと不正抑止を両立

- 公共/交通:混雑や遅延をイベントで共有し、ダイヤ・案内・広告を動的最適化。API経由で民間アプリにも再利用

- 通信:ネットワークテレメトリをイベント駆動で監視し、自動リメディエーション。SLA逸脱を事前に回避

データ品質とガバナンス:エージェント時代の必須チェックリスト

- データ契約(Data Contract):イベント名、スキーマ、SLA、互換性ルールを契約化。Schema Registryで型の破壊的変更を遮断

- リネージ/監査:生成AIの出力は根拠トレースを保持。データ統合の各段を自動記録

- プライバシー:PIIのマスキング/トークナイズ。用途制限をポリシー・アズ・コードで強制

- データ居住:国内リージョン優先。Confluent Cloud(東京)やIBM Cloudのリージョン配置を確認

- モデルガバナンス:watsonx.governanceでリスク、バイアス、説明責任を一元管理

コストとロックインを避ける設計:実装の勘所

- オープン規格駆動:Kafka API、Flink、OpenTelemetryで相互運用性を確保

- ハイブリッド/マルチクラウド:OpenShiftで実行基盤を抽象化。クラウド/オンプレ/エッジを一枚で管理

- IaC/FinOps:TerraformとTurbonomicで容量・コストを自動最適化。トピック/パーティション単位でSLOに応じたクラスターを分離

- データ分解能:高頻度イベントは要約・サンプリングを併用し、必要十分な粒度で保管

他社との比較で見える「IBM×Confluent」の強み

ネイティブサービス中心のクラウド勢(AWS Kinesis/MSK、GCP Pub/Sub、Azure Event Hubs)、DWH/レイクハウス勢(Snowflake、Databricks)にも強力な選択肢がある。

その中でIBMの差別化はハイブリッド適性とガバナンスの深さだ。

- ハイブリッドの厚み:メインフレーム/オンプレ/エッジを含む複雑な現場をOpenShiftで抽象化

- 厳格な規制産業適性:watsonx.governanceと監査・リネージの一体運用

- サービス提供力:大規模移行や現場運用の知見をプロフェッショナルサービスが後押し

一方で、完全マネージド一体型(例えばファーストパーティのDWH+ストリーム一体運用)に比べ、設計自由度が高い分アーキテクチャ責任も重くなる。

そこでデータ契約と自動テストを初期から入れるのが得策だ。

まとめ:クリーンでつながったデータがエージェントを賢くする

IBMのConfluent買収は、「データが動く前提でAIを設計する」時代の象徴だ。

イベント駆動で最新の事実を取り込み、レイクハウスで確証を積み、ガバナンスで安全に配る。

その循環が、エージェント型AIの精度と行動の質を底上げする。

日本企業がいま取るべき一歩は明快だ。

小さく速く始め、データ契約とガバナンスを最初からのせる。

そして、成功パイプラインを水平展開し、組織の“つながる力”を資産に変えることだ。

参考:

IBM Japan Newsroom /

ZDNET Japan /

マイナビニュース /

Confluent Blog /

Bloomberg /

Publickey

コメント